文章目录(Table of Contents)

简介

参考资料

- DeepSpeed-Chat: Easy, Fast and Affordable RLHF Training of ChatGPT-like Models at All Scales,英文文档;

- DeepSpeed Chat: 一键式RLHF训练,让你的类ChatGPT千亿大模型提速省钱15倍,中文文档;

安装 DeepSpeed

可以直接使用 pip 进行安装,详细的说明见下面的链接 DeepSpeed Getting Started:

- pip install deepspeed

安装完毕之后,可以使用 ds_report 来查看是否正确安装。

安装时候如果遇到 CUDA_HOME does not exist, unable to compile CUDA op(s) 的问题,可能是 nvcc 没有安装。首先输入下面的命令查看 nvcc 的版本:

- nvcc --version

- which nvcc

如果是 nvcc 没有安装,下面进行安装。首先查看 CUDA 的版本。ds_report最后可以显示 CUDA 的版本。接着安装对应的 nvcc 即可。也可以使用 conda 进行安装(不同版本的安装链接可以查看 cuda-nvcc):

- conda install -c "nvidia/label/cuda-11.7.0" cuda-nvcc

参考链接:CUDA_HOME does not exist, unable to compile CUDA op(s)

如果想要使用本地的数据集,可以

RLHF 训练流程

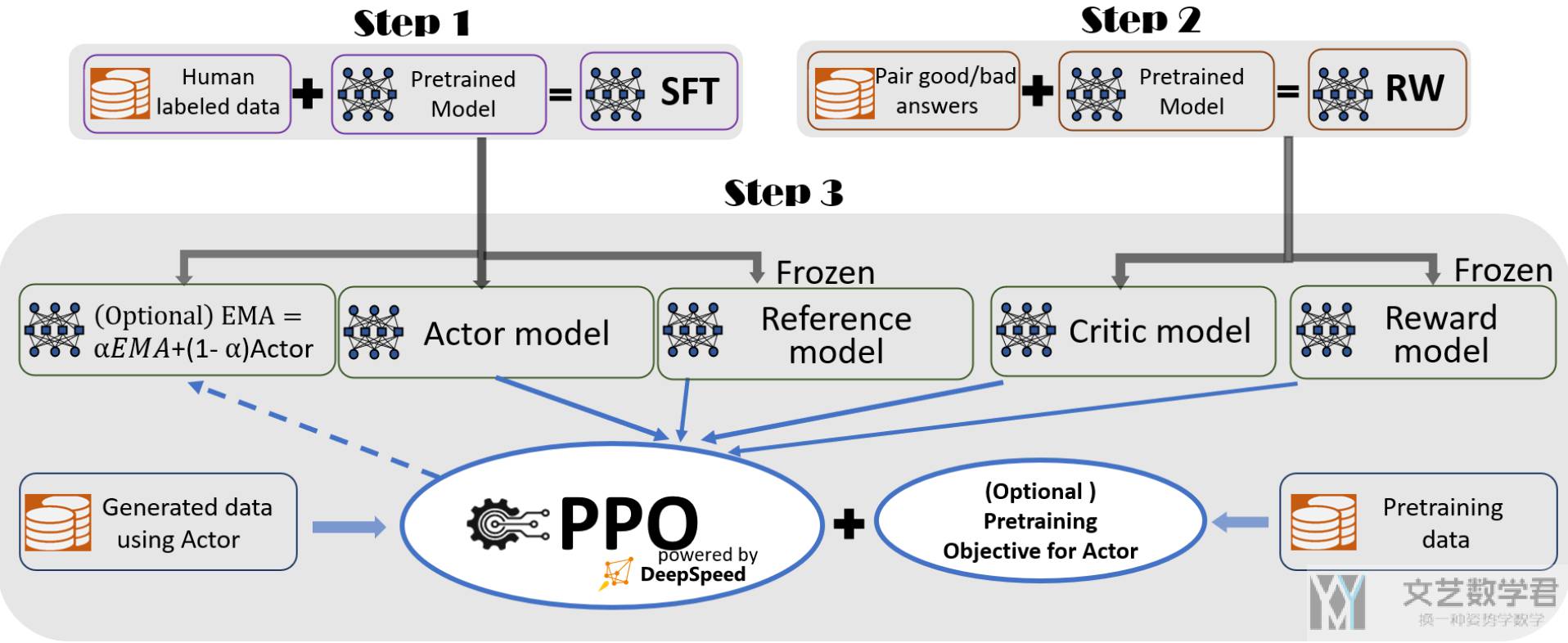

在 DeepSpeed Chat 中,遵循 InstructGPT 论文的方法,完整的流程如下图所示。下面会对每一个步骤进行详细的说明:

步骤一:Supervised finetuning (SFT)

步骤二:奖励模型微调

Reward Model 的输入是由两个部分拼接而成,分别是 prompt 和 response,然后根据 prompt 去给 response 来进行打分。

步骤三:RLHF 训练

为什么步骤一的模型作为 actor model,步骤二的模型作为 critic model,这两个模型结构有什么区别。

State:是一个 prompt

Action:例如一句话有 2048 个词, 每个词从 20000 中进行选择,那么每一次 action 的大小是离散动作吗,就是一次 action 大小就是 (2048. 20000)

Reward 是什么

- 微信公众号

- 关注微信公众号

-

- QQ群

- 我们的QQ群号

-

评论